تعلم عميق بالتعزيز

تعلم عميق بالتعزيز (بالإنكليزية: Deep RL) هو مجال فرعي من التعلم الآلي يجمع بين تعلم بالتعزيز (آر إل) والتعلم العميق. يدرس التعليم بالتعزيز مسألة تعلم الوكيل الحسابي لاتخاذ القرارات عن طريق التجربة والخطأ. يدمج التعليم العميق بالتعزيز التعلم العميق في الحل، ما يسمح للوكلاء باتخاذ قرارات من بيانات مدخلة غير المهيكلة دون هندسة يدوية لفضاء الحالة. تعد خوارزميات التعليم العميق بالتعزيز قادرة على استيعاب مدخلات كبيرة جدًا (يعرض كل بكسل مثلًا على الشاشة في لعبة فيديو) وتحديد الإجراءات التي يجب تنفيذها لتحسين الهدف (تعظيم نتيجة اللعبة). استخدم التعلم العميق بالتعزيز لمجموعة متنوعة من التطبيقات تشمل على سبيل المثال لا الحصر الروبوتات، وألعاب الفيديو، ومعالجة اللغة الطبيعية، والرؤية الحاسوبية، والتعليم، والنقل، والتمويل والرعاية الصحية.[1]

لمحة عامة

عدلالتعلم العميق

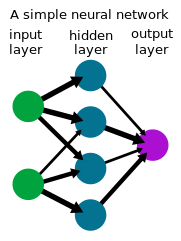

عدلالتعلم العميق هو شكل من أشكال التعلم الآلي يستخدم شبكة عصبونية لتحويل مجموعة مدخلات إلى مجموعة مخرجات عبر شبكة عصبونية اصطناعية. أظهرت طرق التعلم العميق، التي تستخدم غالبًا التعلم بالإشراف مع مجموعات البيانات المصنفة، أنها تحل المهام التي تتضمن التعامل مع بيانات المدخلات الأولية المعقدة وعالية الأبعاد مثل الصور، مع هندسة مقاييس يدوية أقل من الطرق السابقة، ما يتيح تحقيق تقدم كبير في العديد من المجالات بما في ذلك الرؤية الحاسوبية ومعالجة اللغة الطبيعية.[2]

التعلم بالتعزيز

عدليعد التعلم بالتعزيز عملية يتعلم فيها الوكيل اتخاذ القرارات عن طريق التجربة والخطأ. تصمم هذه المسألة رياضيًا غالبًا كقرارات عملية ماركوف (إم دي بّي)، حيث يتخذ الوكيل في كل خطوة في حالة s، إجراء a، ويتلقى مكافأة قياسية وينتقل إلى الحالة التالية s` وفقًا لديناميكيات البيئة (s`ls,a)Ƥ. يحاول الوكيل تعلم نهج π(als) أو المخطط من الملاحظات إلى الإجراءات، لتعظيم عوائدها (مجموع المكافأت المتوقعة). في التعلم بالتعزيز (على عك التحكم الأمثل)، لا تتمتع الخوارزمية إلا بإمكانية الوصول إلى الديناميكيات (s`ls,a)Ƥ عن طريق أخذ العينات.[3]

التعلم العميق بالتعزيز

عدلفي العديد من مسائل اتخاذ القرار العملية، تكون حالات s لقرارات عملية ماركوف عالية الأبعاد (مثل صور من كاميرا أو تيار الاستشعار الأولي من روبوت) ولا يمكن حلها بواسطة خوارزميات التعليم بالتعزيز التقليدية. تتضمن خوارزميات التعلم العميق بالتعزيز التعلم العميق لحل قرارات عملية ماركوف هذه، وغالبًا ما تمثل نهج π(als) أو الوظائف المكتسبة الأخرى كشبكة عصبونية، وتطور خوارزميات متخصصة تعمل جيدًا في هذا الإعداد.[4]

بحث

عدليعد التعلم العميق بالتعزيز مجالًا نشطًا للبحث، وله عدة خطوط بحثية.

استكشاف

عدليجب أن يوازن وكيل التعليم بالتعزيز بين مفاضلة الاستكشاف/الاستخدام: مسألة تحديد ما إذا كان يجب متابعة الإجراءات التي يعرف بالفعل أنها تحقق مكافأت عالية أو استكشاف إجراءات أخرى من أجل اكتشاف مكافأت أعلى. يجمع وكلاء التعليم بالتعزيز عادةً البيانات بنوع من النهج العشوائي، مثل توزيع بولتزمان في مساحات العمل المنفصلة أو التوزيع الغاوسي في مساحات العمل المتصلة، ما يؤدي إلى سلوك استكشاف أساسي. تعد الفكرة وراء الاستكشاف القائم على الحداثة، أو الاستكشاف المدفوع بالفضول، هي إعطاء الوكيل دافعًا لاستكشاف مكافأت غير معروفة من أجل إيجاد أفضل الحلول. يتم ذلك عن طريق «تعديل تابع الخسارة (أو حتى بنية الشبكة) عن طريق إضافة مصطلحات لتحفيز الاستكشاف». يمكن أيضًا مساعدة الوكيل في الاستكشاف عن طريق الاستفادة من العروض التوضيحية للمسارات ناجحة، أو تشكيل المكافأت، وإعطاء الوكيل مكافأت وسيطة مخصصة لتناسب المهمة التي يحاول إكمالها.[5]

المراجع

عدل- ^ Francois-Lavet، Vincent؛ Henderson، Peter؛ Islam، Riashat؛ Bellemare، Marc G.؛ Pineau، Joelle (2018). "An Introduction to Deep Reinforcement Learning". Foundations and Trends in Machine Learning. ج. 11 ع. 3–4: 219–354. arXiv:1811.12560. Bibcode:2018arXiv181112560F. DOI:10.1561/2200000071. ISSN:1935-8237. S2CID:54434537.

- ^ Wiewiora, Eric (2010), "Reward Shaping", In Sammut, Claude; Webb, Geoffrey I. (eds.), Encyclopedia of Machine Learning (بالإنجليزية), Boston, MA: Springer US, pp. 863–865, DOI:10.1007/978-0-387-30164-8_731, ISBN:978-0-387-30164-8, Archived from the original on 2021-03-07, Retrieved 2020-11-16

- ^ A bot will complete this citation soon. Click here to jump the queue أرخايف:1507.04888.

- ^ Schaul، Tom؛ Horgan، Daniel؛ Gregor، Karol؛ Silver، David (2015). "Universal Value Function Approximators". International Conference on Machine Learning (ICML). مؤرشف من الأصل في 2021-01-19.

- ^ A bot will complete this citation soon. Click here to jump the queue أرخايف:1810.12282.